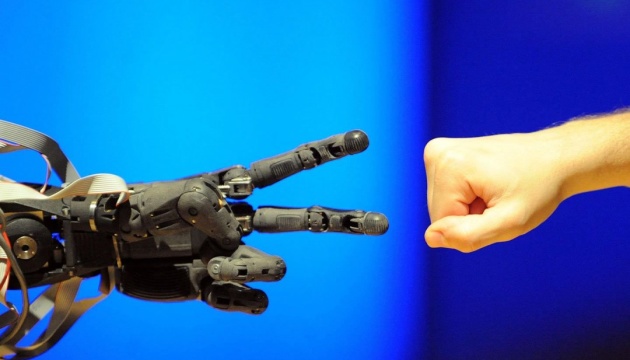

Топменеджери та експерти підписали лист про ризик вимирання людства від штучного інтелекту

Як передає Укрінформ, про це повідомляє Reuters.

"Зниження ризику вимирання через ШІ має стати глобальним пріоритетом поряд з іншими ризиками суспільного масштабу, такими як пандемії та ядерна війна", - написали понад 350 підписантів у листі, опублікованому некомерційним Центром безпеки ШІ (CAIS).

Окрім Альтмана, серед них були керівники компаній DeepMind і Anthropic, а також керівники Microsoft і Google. Також серед них були Джеффрі Хінтон і Йошуа Бенгіо - двоє з трьох так званих "хрещених батьків ШІ", які отримали Премію Тьюринга 2018 року за свою роботу в галузі глибокого вивчення, і професори з різних установ - від Гарварду до китайського Університету Цінхуа.

Подання листа збіглось у часі із засіданням Ради з торгівлі та технологій США-ЄС у Швеції, де політики, як очікується, обговорюватимуть питання регулювання ШІ.

Як повідомляв Укрінформ, корпорація Nvidia заявила, що будує найпотужніший в Ізраїлі суперкомп'ютер зі штучним інтелектом (ШІ), щоб задовольнити зростаючий попит на додатки, де використовуються такі новітні технології.