Коли ти сам не свій: Що таке deepfake і як з ним боротися?

Ми живемо у світі, де тобі можуть показати відео, на якому ти робиш якісь неприпустимі речі – і ти знаєш, що їх не робив. І можуть дати прослухати аудіо, де ти говориш те, що насправді ніколи не говорив. І ти навіть не можеш зрозуміло пояснити: чи твій голос там звучить?

Купа компромату (буквально на кожну більш-менш відому особу) висипається на нас із соцмереж та інтернет-ресурсів. І він настільки якісно створений, що у рядового користувача, глядача і слухача навіть думки не виникає, що це фейк. Адже перед тобою аудіо або відео-документ – як же йому не вірити?

Але все-таки – це фейк. «Deepfake». Вікіпедія так пояснює цей термін, який з'явився нещодавно: «синтез слів «глибинне навчання» та «підробка», методика синтезу зображення людини, яка базується на штучному інтелекті. Вона використовується для поєднання і накладення існуючих зображень та відео на вихідні зображення або відеоролики».

Найвідомішим фейковим відео (далі – deepfake) став сфальсифікований виступ Барака Обами, де він обзивав Дональда Трампа засранцем.

Мільйони людей зайшли на YouTube послухати слова президента, яких той ніколи не говорив. Ніякого скандалу не було, одразу ж в кадрі з'явився режисер Джордан Піл, автор підробки, який пояснив, що цією творчою витівкою він спробував привернути увагу до цифрової дезінформації. Треба сказати, що йому вдалося. Навчитися користуватися програмами та редакторами, які створюють ось такі відео, може будь-який користувач Інтернету. Про революції фальсифікацій почали писати не тільки в технічних журналах.

Ще одним хрестоматійним прикладом глибинного фейку стала ситуація, коли Міністерство оборони Росії «довело» співпрацю США з ІД за допомогою скріншота з комп'ютерної гри. У 2017 році Міноборони РФ опублікувало кілька постів у Твіттері та Фейсбуці, де нібито містилося «незаперечне підтвердження» співпраці США з бойовиками ІД. Насправді – це був обрізаний скріншот з промо-відео до мобільної гри «AC-130 Gunship Simulator», а також відео роботи ВПС Іраку по бойовиках ІД у 2016 році.

Науково-дослідне агентство при Міноборони США протягом останніх двох років працює над створенням технології, яка б могла виявляти подібні високотехнологічні підробки. Медіа пишуть, що на наукові розробки було витрачено близько $68 млн.

Аудіо та відеопрослуховування стають чимось звичним, медіа часто поспішають їх поширити, не заглиблюючись у те, чи може це бути правдою. Чи зможемо ми взагалі з часом довіряти аудіо та відеозаписам? Чи можуть їм довіряти правоохоронці, враховуючи те, як дешево зараз їх сфальсифікувати. Як системно боротися з діпфейками, які стануть нормою життя?

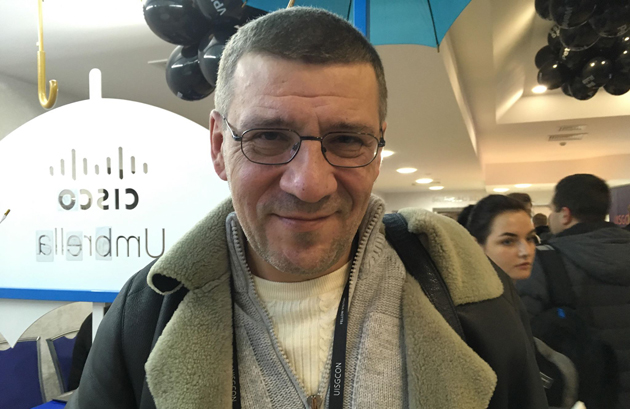

Ці питання ми поставили відомим українським фахівцям з інформаційної безпеки, учасникам 15-ї міжнародної конференції з кібербезпеки UISGCON, що відбулася днями.

DEEPFAKE СТАВЛЯТЬ ЦІКАВІ ЗАВДАННЯ ПЕРЕД ВИРОБНИКАМИ ТЕХНІКИ

Кирило Гобреняк, спеціаліст з інформаційної безпеки:

- Поняття deepfake з'явилося не так давно. Нам можуть передати зображення людини – і вона говорить те, чого раніше ніколи не говорила, візуалізує для нас те, чого не відбувалося.

Тут цікаве завдання – ідентифікувати пристрій, з якого нібито вівся компрометуючий запис. Промовляла чи не промовляла ця людина оприлюднений і компрометуючий текст – тут можлива лише одна відповідь. І отримати (підтвердити або спростувати) її допоможе інформація: чи з цього пристрою вівся цей запис?

Зрештою, в сучасних реаліях пристрій може унікальним ключем підписувати файли. І таким чином достовірність запису буде певною мірою гарантувати те, що він зроблений саме цим пристроєм. Я думаю, що це цікавий виклик для виробників камер – подумати над системою ключів (технологіями), які дадуть таку опцію їхньому продукту.

У банку ми підписуємо ЕПЦ як доказ завдяки нашому ключу. Так само на камері має бути можливість підпису відзнятого на неї відеоматеріалу, який буде доводити, що цей матеріал відзнятий лише цією камерою. І тоді діпфейк не пройде. Як би сама камера доводить, що саме на неї зняли матеріал.

ГЛИБИННИЙ ФЕЙК НЕ ВИТРИМАЄ ЖОДНОЇ ГЛИБИННОЇ ПЕРЕВІРКИ ІНФОРМАЦІЇ

Андрій Логінов, фахівець з інформаційної безпеки:

- Я думаю, що питання діпфейків знімається, якщо виробити звичку диверсифікувати інформацію. Отримали носій з якоюсь інформацією – і одразу ж почали шукати іншу, яка допоможе скорелювати її з відеозаписом.

Наприклад, ми знаємо, що в певний проміжок часу сталася (могла статися) подія, але ми не впевнені: сталася вона чи ні. Набираємо статистично значущу кількість інформації з різних джерел – і порівнюємо.

Підробити всі джерела одночасно дуже складно, а іноді неможливо. Якщо випала невідповідність інформації, ми розуміємо, що її треба перевіряти більш глибоко.

Давайте розглянемо приклад. Є перехрестя, на якому висить 12 камер, сталося зіткнення, поліція приїхала, зняла відео з камер і зафіксувала. Як нам переконатися, що це не 3D-модель, не фейк? Беремо інші джерела, інформацію очевидців, відео з камери, яка встановлена не на перехресті, а у мешканця.

Справжність тієї чи іншої інформації завжди може підкріпити оперативна інформація. Системно боротися з діпфейками не треба, треба мати методики, підходи для того, щоб розуміти – чи модифікована, чи «підготовлена» у спеціальний спосіб отримана інформація.

За наявності інструментарію і додаткових джерел інформації ми завжди зможемо підтвердити або спростувати події з імовірністю 70 або 90 відсотків.

Наприклад, якщо є канал компрометації, і відео або аудіозапис було скомпрометовано, то 70 відсотків нам недостатньо для того, щоб ухвалити те чи інше рішення для оперативно розшукових дій або повірити, що це правда. А 89 відсотків – цього достатньо. Якщо у нас є достатня кількість інформації, то ми можемо вірити і підписатися під цим. Якщо ні, то можемо перевірити і не використовувати.

Мене з точки зору сьогоднішнього дня запитують, чи можна було перевірити достовірність записів, наприклад, касетного скандалу Леоніда Кучми і твердження, що запис вівся диктофоном? Це складно. Оскільки було лише одне джерело. Але якби я записав умовного Кучму або будь-якого іншого один-два-три рази, мав семпли голосу, прогнав через алгоритм зіставлення, і отримав 89% достовірності, то за наявності другого свідка або джерела інформації можна було б довіряти їй більше.

Чи можу я уявити, що персонажем фейку можуть стати важливі особи держави. Можу. Але, знову ж таки, тут постає питання відповідальності журналістів або інших людей, які поширюють це. Так, зараз світ змінюється, і нікому і нічого не можна довіряти. Але він просто диктує нам нові підходи до інформації. Підхід недовіри треба культивувати у всіх.

Я Б НЕ ПЕРЕБІЛЬШУВАВ ЗНАЧЕННЯ DEEPFAKE

Сергій Дяченко, експерт у сфері кібербезпеки:

- Я б не перебільшував значення deepfake. Хоча в цій темі перетинаються найрізноманітніші напрямки. Кіберскладова, цифрова дезінформація та інформаційна війна як поширення фейкового контенту. Плюс – оперативно-розшукова діяльність та її скромна оперативно-технічна складова.

Переконаний, що оперативна робота живого фахівця, яка базується на правильній роботі з агентурою, дезавуює будь-які спроби створити і розкрутити deepfake. Нерозумно як надмірно сподіватися на техніку, так і дуже її боятися.

Будь-який відео- і аудіозапис можна підробити – це правда. Але так само легко можна довести, що він підроблений.

Оперативна робота – основа достовірності, решта – технічне забезпечення. Будь-які модні програми та графічні редактори – лише доповнення. Однією лише органолептикою можна подивитися: бреше чи не бреше цей персонаж. Емоції, поведінкові реакції (коли йому закидається інформація, що розбурхує), стереотипи говорять правду більше, ніж підкинуте відео. Куди більший виклик – змусити людей працювати.

Повірте мені як людині, у якої є розкриті кримінальні справи і по лінії корупції, і по розголошенню держтаємниці. Якби я займався виключно технікою, то жодного з цих результатів не було. Техніка – підмога, інструмент. За будь-якою технікою, будь-якою дією стоїть людина. А проти людини може працювати лише людина.

Звичайно, журналісти підігрівають скандали з прослуховуванням, які так само тягнуть питання достовірності опублікованих записів. Журналістика – на те й журналістика, щоб загострювати і підігрівати, але якщо йдеться про якість, то тут треба перевіряти.

ЯКОЇСЬ МИТІ ФОТОГРАФІЇ І ВІДЕО МОЖУТЬ БІЛЬШЕ НЕ ПРИЙМАТИСЯ В СУДІ

Аліса Міллер, програміст, фахівець з інформбезпеки:

- Згодна, що deepfake – це виклики сьогоднішнього дня і для користувачів, і для урядів. І для виробників, які вже намагаються відповідати на ці виклики. Компанія Adobe вже працює у цьому напрямку: вони випустили оновлену версію фотошопу, яка дозволяє дізнатися – чи було відео або зображення відредаговано, і якщо так, то яка саме частина редагувалася.

Я вважаю, що в Україні це дуже велика проблема. Тому що фейкові відео не мали б жодного значення, якби їх не публікували ЗМІ, які у такий спосіб їх легалізують.

Взагалі, перевірка інформації і так має бути стандартом, але зараз це стає просто надважливим! Україна, на жаль, не готова до таких проблем.

Кібергігієна потрібна усім, хто пише і знімає. Не зберігаючи особисті дані, ви наражаєте на небезпеку тих, чиї контакти у вас є. Не перевіряючи інформацію та публікуючи її, ви ставите під удар ваше видання.

Весь персонал держструктур має проходити навчальні тренінги, в тому числі з повторної перевірки фактів.

Але проблема ризикує стати системною, тому що якоїсь миті фотографії і відео можуть більше не прийматися в суді. Тому робота з протидії deepfake – це і проблема користувачів, і проблема держави, і проблема виробників. Штучний інтелект треба розвивати не лише в бік створення фейків, але і для їх виявлення.

DEEPFAKE: РОЗВИВАТИ ТРЕБА НЕ ЛИШЕ ШТУЧНИЙ ІНТЕЛЕКТ, АЛЕ Й ВЛАСНЕ КРИТИЧНЕ МИСЛЕННЯ

Олексій Барановський, викладач КПІ:

- Deepfake, образно кажучи, – чорний кит, який приплив раптово, але якого було видно здалеку.

Будь-який інструментарій спочатку використовується тими, ким він замислювався з метою, для якої призначався. Потім розширюється коло тих, хто користується і цілі, для яких використовується. Свого роду цифрова діалектика.

У 2011-2012 роках наші недруги заходилися масово використовувати інформоперації. Для їх проведення залучали цілі батальйони людей – для створення і просування неправдивого контенту. Але з часом до такої інформації виробився певний імунітет. З'явилися способи швидко перевіряти інформацію. Постало завдання, як робити фейки, щоб вони були правдоподібними.

Чому вірить людина? Тому, що здається правдою. Вона починає вірити фейку, коли її очікування одразу ж підтверджуються, у тому числі відео- і аудіозаписами. Правильно підготовлений фейк (скріплений «відео», «аудіопідтвердженнями») відповідає настроям.

Щоб глибоко розбиратися у фейках, слід розвивати критичне мислення, тому що більшість людей вірить у те, що просто здається їм правдою.

Звучать пропозиції про те, щоб подумати над цим виробникам. Але будь-які "водяні знаки" не вирішать проблему готовності та бажання людей вірити в те, що підживлює їхні настрої.

Розвиток штучного інтелекту не вирішить проблему розвитку інтелекту і мислення у людей – споживачів фейків.

Лана Самохвалова, Київ